Jaan Tallinn é um engenheiro fundador da Skype e Kazaa. Ele fundou a Centro de Estudos do Risco Existencial e é também cofundador da Instituto Futuro da Vida e apoia filantropicamente outras organizações de investigação do risco existencial.

Foi recentemente entrevistado pelo The Guardian sobre o tema do potencial da IA para acabar com a civilização humana. É uma excelente - embora longa - leitura, com algumas citações e ideias interessantes. Eis alguns dos meus excertos preferidos:

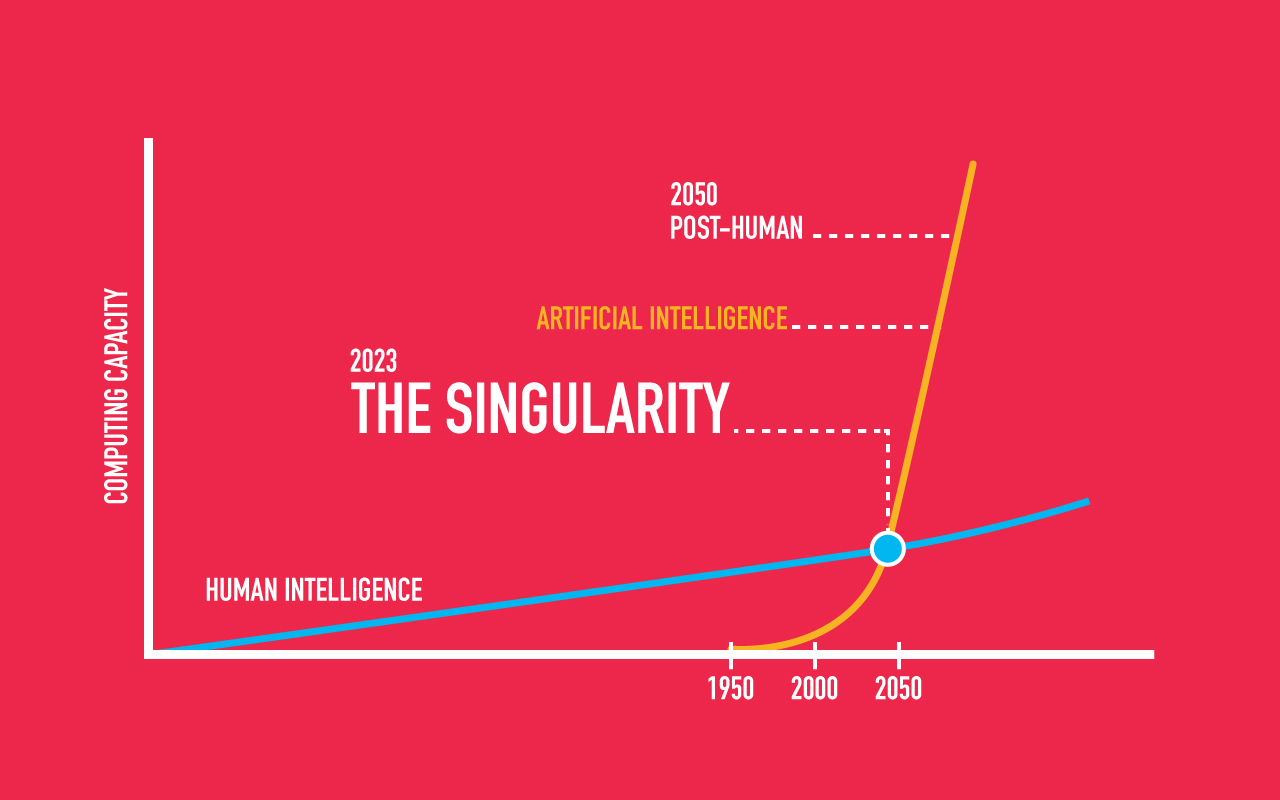

"Concordo que ... a preparação para a eventualidade de a IA geral ultrapassar a inteligência humana é uma das principais tarefas da humanidade".

"Se a estrutura de recompensas de uma IA sobre-humana não for devidamente programada, mesmo os objectivos benignos podem ter fins insidiosos.

"A IA superinteligente traz ameaças únicas. Em última análise, espero que a comunidade da IA possa seguir o exemplo do movimento anti-nuclear da década de 1940. Na sequência dos bombardeamentos de Hiroshima e Nagasaki, os cientistas uniram-se para tentar limitar a realização de novos ensaios nucleares. Os cientistas do Projeto Manhattan podiam ter dito: "Olhem, estamos a inovar e a inovação é sempre boa, por isso vamos em frente... Mas foram mais responsáveis do que isso."

"Tallinn propôs não só encerrar a superinteligência num tanque de retenção - uma estrutura física - mas também restringi-la a responder a perguntas, como uma pessoa muito inteligente Tabuleiro Ouija. A abordagem que mais entusiasma os investigadores é encontrar uma forma de fazer com que a IA adira aos valores humanos - não os programando, mas ensinando as IA a aprendê-los. Num mundo dominado pela política partidária, as pessoas debruçam-se frequentemente sobre as diferenças entre os nossos princípios".

Quando questionado sobre o que poderá ser o sucesso na segurança da IA, Tallinn referiu-se a o Lfilme do ego onde "...tudo é espetacular".

Publicação convidada do curador de conteúdos da The Futures Agency Petervan

Outros recursos